Nous vivons une époque formidable. Mais si ! Depuis des années, on nous parle de sécurisation de l’informatique personnelle. Je suis entièrement d’accord, il faut sécuriser l’informatique, surtout à une époque d’ultra-connectivité.

Cependant, l’énième avatar de cette volonté de sécuriser l’informatique, à savoir la technologie SecureBoot (et l’effet « indésirable » que cela entraînera à terme sur la communauté du libre au plaisir non dissimulée de Microsoft, comme je l’ai exprimé sur un article écrit pour Chatinux), risque de provoquer la naissance d’une informatique où la défiance sera la règle.

Depuis le projet « Palladium » de 2003, tous les efforts pour rendre l’informatique plus sure se résume à rajouter verrous sur verrous, clés sur clés. Depuis la célèbre puce Fritz les efforts ont été constants.

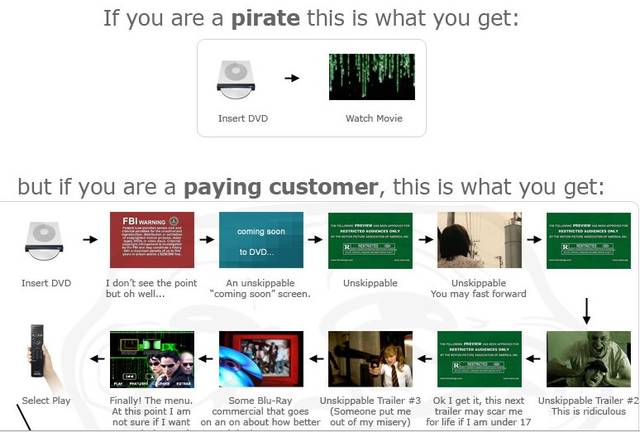

Les verrous numériques ont fait depuis longtemps la preuve de leur inefficacité ou de leur nuisance envers les utilisateurs honnêtes. Les verrous des DVD et des BluRay ont soit été cassés soient contournés. Cette course à l’armement sera sans fin.

Quand on me parle du principe de SecureBoot, qui n’autorise le démarrage que si la clé annoncée par le système d’exploitation est autorisée donc valide, ça me fait penser à une scène du film « Gattaca« .

Dans cette scène, on voit la population « valide » accéder à leurs lieux de travail en se basant sur une goutte de sang, comme une clé pour ouvrir une porte. Des outils vérifient que cette goutte de sang est celle d’une personne qui a le droit d’accès ou pas.

Mais il ne faut pas oublier que d’autres étapes de cette informatique signée existe dejà : par exemple l’AppleStore ou encore la fonctionnalité GateKeeper du futur MacOS-X Mountain Lion.

Car l’informatique dite « de confiance » ne pourra l’être sans une forme minimale de censure. Censure technologique qui sera l’utilisation de clé qui donnera l’autorisation ou non au système d’exploitation de lancer l’application.

D’ailleurs, le principe existe depuis des années sur MS-Windows, avec les pilotes dit WHQL. Cependant, on peut toujours installé un pilote non-WHQL, le système prévenant l’utilisateur.

On ne protègera pas uniquement l’informatique par l’obscurité et l’empilement de verrous plus ou moins solide. Un minimum de pédagogie et d’information est nécessaire.

SecureBoot est une mauvaise réponse à une bonne question : comment éviter que des logiciels vérolés ne démarre sur une machine ?

Et pour finir, je reprendrais la conclusion de mon article sur Chatinux :

Tirons donc notre chapeau à l’enseigne de Microsoft qui en combattant le problème des machines qui pourrait faire démarrer une version frelatée (piratée ?) d’un OS, cela aura comme effet “kiss-cool” de se débarrasser d’un concurrent minuscule : GNU/Linux. Quoique la communauté GNU/Linuxienne s’occupe très bien de son cas toute seule, comme j’ai pu l’écrire sur mon blog personnel, avec un billet teinté d’humour acide.

En voulant conforter l’utilisateur en lui disant : avec telle et telle technologie tu seras à l’abri, cela créera d’abord un sentiment fallacieux de sécurité et engendrera une défiance envers l’outil informatique au final.