Durant des années, j’ai présenté et testé des distributions GNU/Linux dans le cadre de machines virtuelles, avec toujours la même rengaine : « Tu ne testes pas en dur, ça vaut rien. »

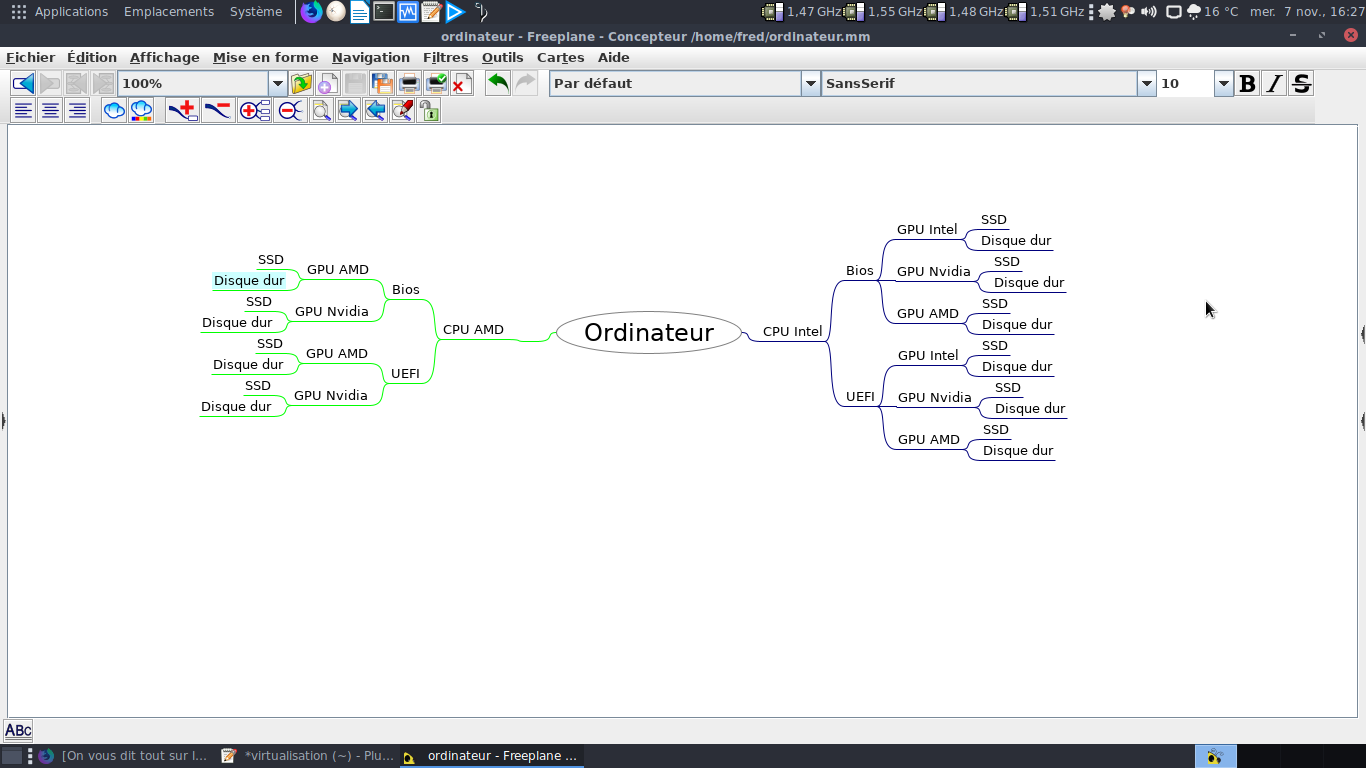

Ouvrons un logiciel de carte heuristique – aussi connue sous le nom de carte mentale – qui permet d’organiser les idées en partant d’un point et en tirant chaque pensée au maximum. Pour cet exercice, j’ai pris freeplane.

Combien faudrait-il d’ordinateurs différents pour couvrir un minimum de points communs, au minimum le trio suivant :

- le CPU

- le circuit ou la carte graphique

- le type de la carte mère, à savoir Bios ou UEFI

Pour le premier point, on a déjà deux options : soit du Intel, soit de l’AMD.

Pour le deuxième point, on a trois options : soit du Intel, soit de l’AMD, soit du Nvidia. Ce qu’on peut décomposer en :

- CPU Intel, graphique Intel

- CPU Intel, graphique AMD Radeon

- CPU Intel, graphique Nvidia

- CPU AMD, graphique AMD Radeon

- CPU AMD, graphique Nvidia

Soit cinq possibilités ne serait-ce qu’au niveau du duo CPU et graphique. Qu’on multiplie par deux pour les cartes mères à base de Bios et d’UEFI. Ce qui fait déjà dix possibilités. Et encore, je n’ai pas parlé de l’utilisation du support de stockage : disque dur, SSD classique / M2.

Ce qui donne 20 options. À ne pas oublier de multiplier par deux pour prendre en compte à la fois les ordinateurs fixes et les portables. Vous imaginez l’encombrement ? Le nombre d’ordinateurs nécessaires ?

Sans oublier d’autres points comme les circuits réseaux (filaire ou sans fil ?), lecteur optique ou pas, lecteur de carte SD ou pas ?

Sans oublier d’autres points comme les circuits réseaux (filaire ou sans fil ?), lecteur optique ou pas, lecteur de carte SD ou pas ?

On finit par ne plus savoir où donner de la tête. C’est pour cela que j’avais choisi de prendre des machines virtuelles. Un environnement reproductible à l’infini, modulable à l’infini.

Évidemment, ce n’est pas parfait, mais au moins, cela donne une machine modèle idéale pour reproduire mes vidéos si le besoin s’en faisait sentir.

Mais cela doit être trop compliqué à comprendre… Mais il est vrai que notre ordinateur est représentatif de celui du voisin ou de la voisine… Ou encore d’une personne vivant à 150 km de chez nous.

Vous trouverez ci-joint le fichier au format freeplane.

Amusez-vous donc à rendre le graphique vraiment exhaustif, je vous souhaite bien du courage 🙂

Je pense que ce qui est reprocheé dans un test en environnement virtuel est plus lié aux performances. Les IOPs sont réduites et l’accélération graphique est plutôt aléatoire malheureusement.

Si les tests se concentrent sur d’autres points ( et c’est ce que tu fais ) un environnent virtuel n’est pas un problème et possède même un avantage de neutralité vis à vis du matériel.

PS: jai un peu honte d’avoir utiliser la calculatrice pour le captcha 😉

La perte de performances « pures » doit être de l’ordre de 5 à 10% avec du vent dans le dos. Pour la 3D, je le concède, c’est la merde.

Ca fait un moment que les IOP ne sont plus un problème en virtualisation. Je parle d’ordre général, pas de Virtualbox en particulier, que je trouve extrêmement pratique néanmoins, et difficile de s’en passer pour faire des tests.

J’espère que tout le monde à bien conscience qu’aucun géant du web, les GAFAM en tête, ne font du physique.

Rien à rajouter ici, tout est dit !

plus de vidéo depuis un moment, pendant combien de temps, encore avant de revenir ?

si çà intéresse je peux prêter ma chêne au cas ou , perso je vais bientôt redémarrer de manière hallucinante.

donc si tu as des choses a dire sur youtube….

Je suis coincé jusqu’au lundi 12 au minimum. Et je t’avoue que je compte mettre un coup d’arrêt à ma présence en tant que créateur de vidéo sur Youtube.

Ça m’a bouffé la vie et m’a coupé de mes autres passions. Pour des « apparitions », pourquoi pas, mais pour le moment, je veux faire autre chose 🙂

Une chose qu’il faut mettre dans la balance, c’est que si dans une machine virtuelle ce n’est pas concluant, il y a quand même de grandes chances pour qu’en dur ce ne soit pas bien mieux, je trouve que ta méthode est bonne et si les gens veulent tester en dur cela ne me pose pas de souci, c’est pas ma machine 😀

A pluche.

Après, chaque personne voit midi à sa porte.

Bonsoir,

Même sur mon portable de 2011 je peux faire tourner une distribution en machine virtuelle.

Donc oui c’est pertinent de tester une distribution en virtuel. Ce qui est important c’est de voir si c’est léger en mémoire, s’il y a des applis pertinentes installées et si elles ne sont pas en doublon.

Installer en dur pour tester c’est vraiment pour faire du test à la phoronix…

Et encore, on critiquera Phoronix d’utiliser tel CPU, tel GPU, etc…

Je lâcherai bien un bon petit troll en disant qu’on peux simplifier en prenant des ordinateurs qui savent démarrer en BIOS et en UEFI et qu’ils peuvent avoir une carte WiFi et de l’Ethernet 😉

Enfin bon, je suis d’accord avec toi, le but est juste de présenter/tester le bon fonctionnement et de toute façon, une distro qui ne fonctionne pas correctement dans VirtualBox à du souci à se faire en conditions réelles.

Il ne faut pas dire tout cela trop fort !

Hello Fred,

Fais tes tests avec QEMU/KVM 😛

https://hedilenoir.com/index.php/2018/10/21/virtualisation-materielle-libre-sur-debian-jessie/

Sinon je fais pas partie de ceux qui te critiquent mais vu que tu utilises virtualbox au quotidien pourquoi pas tester ? 🙂

@+

J’ai utilisé qemu aussi au fil de années… Et je maintiens actuellement – début novembre 2018 – le paquet qemu-git sur AUR… Donc…

Je ne sais pas si mon commentaire va être compris !

Pourquoi ?

Ici on parle d’informatiques et de tests chez des particuliers pour des particuliers. Et le particulier, donc la personne qui utilise l’outil informatique de façon classique à du mal avec la virtualisation !

Ce qu’il faut savoir c’est que la virtualisation est partout en entreprise ! Quand je dis partout c’est partout ! On virtualise tout et à tout va ! Que ce soit les systèmes server, les systèmes desktop, les serveurs physiques, les espaces de stockages sont même virtualisés. Bon maintenant on va oublier nos joujou VirtualBox et Workstation de VMware. On partira sur de l’hyperviseur type 1 comme Hyper-V, Xen, Proxmox, ESXI, etc… Le tout avec du passthrough GPU pour ne citer que lui…

Je me souviens avoir eu un commentaire qui disait « la virtualisation c’est de la merde, vous me faites ch… avec ça! ». Et ben… Je n’ai même pas envie de répondre tellement c’est d’un ridicule. Parfois j’ai envie de prendre la main de certaines personnes et leur faire visiter quelques endroits où tout est virtualisé !

Je ne sais pas toi, mais pour ma part j’ai un pied dans l’informatique aux particuliers, et un dans l’informatique aux sociétés ! Donc je peux comprendre que l’utilisateur normal, qui utilise sa machine normalement, ne connaissent pas la technologie en entreprises qui est à des années lumières de l’utilisation que l’on n’a d’un PC chez soit ! Mais alors bon sens, croyez-nous quand on vous dit que vous vous trompez !

Je viens de retrouver un exemple de commentaire que j’ai déjà reçu : https://blablalinux.files.wordpress.com/2018/11/commentaire-virtualisation.png

… et puis que ce soit en VM ou en réel, l’ergonomie, l’esthétique (donc la facilité d’utilisation et la lisibilité), la logithèque, les outils pas si accessoires (voir leur manque comme dans Fedora) et d’autres particularités de ce genre sont, de façon équivanlente, visibles et critiquables dans le sens originel du terme de façon parfaitement identique. Et c’est pour moi l’essentiel.

A+

Il y a aussi l’alternative de l’essai en session Live, avec une clé USB.

Techniquement, c’est assez facile à faire pour les distributions qui le proposent. Et en général le résultat est très proche de l’installation en dur ( sauf pour 2 ou 3 détails style pilote graphique proprio, etc… )

Par contre, l’inconvénient c’est que la clé USB en question qui servira pour accueillir des distributions prendra cher, et risque de ne pas durer très longtemps ( je peux en témoigner lol )

Et puis je dois reconnaitre que je n’ai pas vraiment idée des contraintes pour faire ensuite une vidéo et la publier sur You Tube en utilisant cette méthode.

Le problème est qu’il faut filmer l’écran depuis l’extérieur. Je ne te dis pas les contraintes techniques de tournage.

Il est vrai que les clés USB dans ce cas prennent très cher et ont une durée de vie des plus limitée…

En plus, si le souci c’est la performance, les IOPS en USB c’est pas exactement comparable à du SSD en SATA…

Aussi. Mais si un environnement est lourd en virtuel – grosse gourmandise en ressources – ce sera aussi le cas en réel.

Il est vrai que des environnements comme Gnome ou Cinnamon sont des poids plumes dans le domaine 😀

Il y a aussi moyen d’installer une distribution sur une clé usb, c’est quelque chose que je fais quand je pars visiter la famille de ma femme à l’étranger ou même parfois pour utiliser au boulot, comme ca je peux utiliser leur ordi sans toucher à leur OS et j’ai mon environnement à moi, avec mes paramètres, mes favoris, etc. Bon évidemment les perfs c’est pas comme sur mon SSD, mais la clé USB de 64Go elle tient bien le coup.

L’avantage est de pouvoir installer les softs (simplescreenrecorder par exemple) et les pilotes dont on a besoin.

Je ne suis pas fan des ISO live, c’est dur de tester sans rien pouvoir installer et sans pouvoir appliquer les mises à jour. Dans ce cas, je préfère de loin l’utilisation d’une machine virtuelle.

Les clés USB, c’est pratique, mais c’est fragile et les utiliser comme OS nomade est une bonne idée mais aussi une mauvaise.

Pour ta conclusion, je suis d’accord.

Comme autre logiciel il y a aussi XMIND à mon sens plus complet.

J’ai un reproche à faire à virtualbox, c’est que toutes les cartes son de la machine hôte ne sont pas reprises dans la configuration de la machine invité et cela a faussé mes tests. Et impossible à modifier dans la configuration

Puis KDE aussi est un veau… Tout ça n’est pas toujours copain avec la virtualisation mais c’est pas fondamentalement ce qui va changer une distro. Et perso je trouve que les bureaux « légers « basés sur gnome2 (xfce et mate) commencent à accuser un certain retard.

J’ai utilisé virtualbox des années, puis je me suis décidé à prendre vmware. Ok c’est proprio mais le fonctionnement de tout ce qui est environnement graphique a plusieurs années d’avance. Si quelqu’un a besoin de virtualisation au quotidien et d’un bureau qui supporte l’accélération, ça vaut la peine d’investir dans la licence quitte à passer pour un être *impur* aux yeux de certains, mais bon il y a longtemps que je ne recherche plus l’approbation de ces gens.

Tout dépend de ce que tu veux tester. Si c’est l’érgonomie, les fonctionnalités, bref pour se faire une idée générale… le hardware n’a aucune importance. Si c’est pour des tests de performances, pour mesurer l’utilisation des ressources, de la consommation/autonomie, etc. alors c’est une tout autre histoire et là il vaut mieux se tourner vers phoronix. Et pour la petite histoire, il suffit généralement de chercher sur les caractéristiques techniques (chpiset) pour savoir si les pilotes sont disponibles, à partir de quelle version du noyau c’est supporté & cie. Reste le problème du support partiel et des mauvais pilotes ou de la mauvaise intégration, mais on peu déjà bien débrouisailler rien qu’avec quelques recherches (ce que je fais par exemple AVANT d’acheter du matos).

Pour en revenir au test de distributions, ce qui est domage selon moi, c’est que bien souvent c’est seulement un survol plus ou moins rapide : on l’installe, on vérifie les n° de version du noyau et de quelques applications phares, on ressence les problèmes rencontrés (et leur éventuelle résolution, ce qui est vraiment très bien) et on descend en flamme la distribution si il y a des problèmes de localisation. Par exemple, on ne vérifie jamais certains composants secondaires ou librairies pour voir leur fraîcheur, on se contente de gratter légèrement la croûte sans creuser, on va rarement à la rencontre de la communauté ou des devs pour un peu discuter avec eux et enrichier l’article d’autres expériences, avis, … On ne s’intéresse jamais à l’architecture sous jascente (comment sont hébergés les dépôts, quels sont les systèmes de redondances, le flux complèt de la création/mise à jour des paquets jusqu’au moment où ils arrivent chez l’utilisateur… par exemple quels sont les outils de suivi des mises à jour « upstream »/des alertes de sécurité, comment les paquets sont validés, comment sont-ils testés, …

Je vais répondre rapidement aux points que tu développes.

Bref, tu as des remarques qui auraient été intéressantes vers 2012 – 2013 mais qui avec le degré de maturité actuelle – en dehors des grosses bouses à la Antergos, Namib, RebornOS, les soeurs ennemies qui descendent de Mandriva Linux pour citer les principales qui me viennent à l’esprit – ont perdu tout intérêt pour la plupart des utilisateurs et utilisatrices en cette fin 2018.

Bref, il faut peut-être se dire que si le monde du bureau libre veut avancer, il serait temps de proposer une poignée de distributions solides et bien conçues, traduites au maximum dans la langue de la personne qui installe un OS basé sur Linux que de faire ad-nauseam un concours de bites.

Au risque de passer pour un gros troll, je dirai que ce sont justement ces utilisateurs qui devraient bouder un desktop linux.

Ensuite il faut savoir que les traductions c’est pas le job intéressant, maintenir de la rétro-compatibilité non plus c’est pas un job intéressant. Le fondateur de gnome, (le vilain mexicain traître à l’open source), l’avait assez clairement dit dans une vieille interview en 2010 ou 2012: La majorité des contributeurs sont là pour ne faire que ce qui les intéressent, réinventer les nouvelles choses, déprécier les anciennes sans honte, casser la compatibilité pour résoudre des problèmes que les utilisateurs ne savent même pas qu’ils ont etc…

Du coup on a plein de distros qui n’existent que pour des soucis d’opinions politiques ou parce que les auteurs ont voulu se mettre en avant avec un pack d’icone différent. Rien de tout ça n’est motivé par le besoin réel, et rien n’est motivé par le besoin financier.

Ils ont su faire un bon moteur, ils se sont pas mis d’accord sur la carosserie.

Ton commentaire est parfait et tu prèches un convaincu. Sur ta conclusion, je dirai qu’on est dans le syndrome d’OS/2 d’IBM : un moteur de bonne qualité mais une carrosserie à chier.

La comparaison tient assez bien. Dans le cas d’OS/2, il en est ressorti que l’excellence technique des couches basses n’a pas pu tout sauver. Et c’était pourtant sans doute un argument encore plus puissant qu’aujourd’hui tant les ressources systèmes étaient limitées et chères.

Je pensais bien que tu partagerais effectivement cette opinion, ici j’ai déjà vu dénoncer plusieurs fois le manque de cohérence générale, les distros inutiles et les stupides forks qui font de la situation ce qu’elle est.

OS/2 était et reste aujourd’hui l’un des meilleurs, si ce n’est le meilleur OS ayant jamais été conçu. Et quand je dis cela, je ne suis pas un lambda mais un expert dans le domaine des systèmes d’exploitation avec des années d’expérience. Quand je dis que OS/2 est le meilleur OS, ce ne sont donc pas des paroles en l’air, mais un avis d’expert.

Si tu as des questions ou des interrogations à ce sujet, n’hésite pas à m’en faire part. Je serai alors ravis de partager mes larges connaissance dans ce domaine.

1. En 2050, le problème existera encore, tout dépend de l’intérêt des constructeurs… faire des pilotes libres en reverse engineering sans l’aide du constructeur c’est se retrouver avec une carte nvidia et des pilotes nouveau.

2. Si c’est une distribution qui développe beaucoup d’outils et qui est composée d’une petite équipe ou qui laisse la communauté s’occuper des traductions, on peut avoir un très bon produit mais dont les traductions peuvent être d’un niveau très variable. Exemple : Solus.

3. Il y a des auto-convancus partout, tout comme il y a aussi des personnes objectives. Tu as choisi ArchLinux et tu ne la conseillerais pourtant pas à tout le monde, et tu reconnais qu’il y a à boire et à manger dans les dépôt AUR… Tu fais partie de la communauté Arch et tu n’es pas un auto-convaincu… tu te contredis !

4. Tu ne t’adresse pas aux technophiles mais tu précises que ton blog est assez technique. Un autre paradoxe 🙂

Il me semble que c’est toi qui a écrit il n’y a pas longtemps que ça devenait dur de trouver des idées de sujet après autant de temps et que tu commençais à te lasser car ça devient répétitif à la longue mais d’un autre côté tu ne sembles pas avoir envie de changer de formule (bon ce sont peut-être mes suggestions qui sont toutes pourries)

Elle existent: Debian, Ubuntu, Fedora… Il suffit grosso-modo de se limiter aux 10 principales distributions, la liste change peu au fil des années.

Réponse rapide :

Point 1 : si en 2050 je suis encore en vie et les systèmes linux aussi, on en est encore à ce point précis, ce sera un sacré échec.

Point 2 : les petites équipes ne sont pas viables sur le long terme, spécialement si elles partent de la feuille blanche. Cf les péripéties de la Void ou encore de la Solus qui ont perdu toutes les deux leurs fondateurs cette année. Je ne sais pas si les deux seront encore en vie d’ici 5 ans, mais je ne le pense pas. Je voudrais bien être trompé.

Point 3 : dans les communautés, qui se détestent parfois, ce sont toujours les plus zélotes, les plus prosélytes qui se font entendre. J’ai appris à prendre du recul et rester honnête envers les limites de la distribution que j’utilise au quotidien depuis bientôt 10 ans.

Point 4 : il est assez technique du fait que je parle d’une informatique qui est parfois difficile à aborder par les utilisateurs et utilisatrices « lambdas / michus / basiques »

Je dis simplement que le monde du libre dans le domaine des distributions GNU/Linux bureautique est surchargé. Que la moitié des distributions de ce domaine indexées sur Distrowatch pourraient disparaître sans que la situation ne soit critique.

Pour ta conclusion, j’en reviens toujours au même point. Les seules distributions vraiment utiles en 2018 ?

Les distributions mères, par ordre alphabétique : Archlinux, Debian, Fedora / RHEL / CentOS, Gentoo/ Funtoo, OpenSuSE (qui a appartient à qui maintenant ?) et Slackware.

Leurs filles, à savoir respectivement : Manjaro, Ubuntu et ses saveurs officielles, pour Fedora et OpenSuSE je ne vois pas, Calculate Linux, SalixOS et ZenWalk.

Je rajouterai des projets comme Emmabuntüs ou encore DFLinux. Ce sont les principales qui me viennent à l’esprit. J’ai du en oublier certaines, mais en dehors de cette quinzaine de distributions, est-il besoin d’aller voir ailleurs ?

Si tu prends le top 10 / 15 de curiosité de Distrowatch, tu remarqueras que j’ai cité facilement les 3/4 des distributions en ayant fait partie depuis 2002.

@Jean-Louis

Jusqu’ici ça manquait un peu d’humour dans les commentaires. Merci à toi

Petite question : tu travailles pour IBM ?

PS : pour un OS mort depuis bientôt 15 ans, tu aurais pu employer le passé

drendolen, je pense que l’on peut dire tu n’y connais rien en systèmes d’exploitation, pour sortir de telles âneries. Pour ta gouverne, OS/2 n’est absolument pas mort. Il a tout simplement changé de nom.

https://www.arcanoae.com/arcaos/

En ce qui concerne l’OS/2 original, si il n’évolue plus, c’est tout simplement qu’il fonctionne et qu’il n’a pas besoin d’évoluer. Contrairement aux concurrents, il n’est pas truffé de bugs. Ce système est utilisé dans un important nombre de systèmes critiques (centrales nucléaires, hôpitaux, etc …). Ce n’est pas un OS de rigolos. Et ça fonctionne sans incidents. C’est pour cette raison que j’affirme qu’il s’agit du meilleur OS ayant été conçu. Son niveau de qualité est inégalé a ce jour.

Ceux qui souhaitent un OS/2 remis au goût du jour peuvent tout simplement utiliser ArcaOS. Je vous conseil de tester, cela en vaut la peine.

Il est important de rappeler que je suis un expert reconnu internationalement, et plus particulièrement en systèmes d’exploitation. Toutes les affirmations que je fait ici ne sont donc pas celles d’un simple amateur, mais d’un véritable professionnel reconnu dans le milieu. Il ne s’agit pas de paroles en l’air mais le résultat de longues analyses techniques.

Je pense qu’il est important de le souligner pour éviter les réponses tels que celle de drendolen, qui nous a fait la démonstration de ses piètres connaissances dans le domaine.

Il va de soi que les ricanements de drendolen ne remettent absolument pas en cause la pertinence de mes analyses.

ok, j’y connais rien et toi tu sais tout. c’est sans doute vrai, mais je vois pas le rapport en os/2 et ce billet. et je dirais même entre os/2 et le reste. c’est comme dire que l’OS cisco ou juniper sont les meilleurs, ça n’a pas vraiment de sens. le meilleur pour faire quoi, quels sont les critères etc …

pour moi le (les) meilleur OS c’est celui que j’utilise 😉

Je parle au niveau technique. OS/2 est techniquement le meilleur OS ayant jamais été conçu. Et cela je le dit en tant qu’expert en systèmes d’exploitation. Je sais bien que les amateurs peuvent avoir du mal à comprendre ce que je veux dire par la, mais les professionnels comprendront. Et encore, je ne suis pas rentré dans les détails pour simplifier mes propos, mais il y aurait tant de choses à dire si l’on voulait approfondir … Mais il serait contre productif de rentrer plus dans les détails avec des amateurs, car j’ai déjà bien du mal à me faire comprendre ainsi. Je vais donc me contenter de cette affirmation: OS/2 est au niveau technique le meilleur OS ayant jamais été conçu jusqu’à maintenant, et il le restera probablement durant les prochaines décennies. Et ce n’est pas uniquement moi qui le dit, il y a un large consensus des experts sur ce domaine. J’espère avoir clarifié les choses.

Quand au rapport entre ce billet et OS/2, c’est monsieur Bezies lui même qui a commencé évoquer le sujet dans l’un des commentaires.

En ce qui concerne l’OS cisco j’ai quelques réserves importantes en ce qui concerne la qualité de leur implémentation et de leurs conception technique. Mais il s’agit d’un sujet complexe, trop complexe pour un amateur. Je ne vais donc pas entrer plus dans les détails.

Je n’ai pas l’impression d’avoir mentionné que j’étais un amateur …

Vu que tu n’as absolument rien dit ou expliquer hormis le fait que tu est un expert et qu’OS/2 est le meilleur, j’imagine qu’on va s’en contenter.

Maintenant, quel est le meilleur OS pour un gamer ? pour un NAS ? LIbre et gratuit ? Pour le montage vidéo ou audio ? Les super-calculateurs ? Pour les routeurs/pare-feu ? etc … Est-ce OS/2 à chaque fois ?

Il n’est pas nécessaire que tu précises être un amateur pour que cela se note au premier coup d’œil.

Quand au reste de tes questions, je n’ai jamais prétendu que OS/2 était le plus adapté à toutes les situations. Ce n’est pas le cas et aucun OS ne l’est. Tout ce que j’ai affirmé, c’est que techniquement, OS/2 est le mieux conçu de tous, et de loin. C’est une discussion d’experts en système d’exploitation. Une discussion plus théorique que pratique. Les amateurs ont souvent du mal avec les discussions théorique et ne voient que la pratique, celle qui est simple à comprendre. C’est normal, une discussion théorique demande beaucoup plus de bagage technique et d’expérience dans le domaine. Ce genre de discussion se faire généralement entre experts de haut niveau et l’on peut voir ici ce que cela donne lorsque des amateurs s’en mêlent.

Tout ce que je me suis permis d’affirmer ici, c’est que dans la technique et la théorie, OS/2 est l’OS qui devance tous les autres. J’admets bien volontiers que dans la pratique il n’est plus le leader dans tous les domaines. Cela n’enlève pas ses qualités intrinsèques. Un retour au devant de la scène n’est pas non plus à ecarter dans les prochaines années.

Sache que j’ai assisté à certaines des conférences parmi les plus prestigieuses, aux quatre coins du monde. Dans les années 90 j’ai eu la chance de rencontrer lors d’un dîner l’un des concepteurs d’OS/2. Je baigne dans ce milieu depuis un certain temps, ce ne sont donc pas des paroles en l’air.

Je vais sans doute regretter de m’en mêler mais bon….

Je rejoins Drendolen lorsqu’il dit qu’un OS doit aussi être jugé en fonction de sa pertinence pour un domaine d’utilisation et pas seulement sur des critères purement techniques. C’est pas parce qu’il ne dîne pas à la table des concepteurs d’OS/2 que son constat est nécessairement de la connerie.

Il faudrait voir quels investissements sont faits de nos jours dans les OS/2 car clairement au risque de me faire traiter d’ignare à mon tour, pour moi OS/2 c’était en déclin depuis longtemps. Ce que je sais d’OS/2 c’est qu’il a raté sa chance de s’imposer malgré des qualités techniques incontestables, et je pense pouvoir affirmer sans me tromper que c’était pas la première ni la dernière fois que cela arrivait dans le monde de l’ingénieurie.

ArcaOs, je ne savais même pas que ça existait et j’ai pas l’impression que c’est extrêmement mainstream, ni que c’est un système qui peut attirer les éditeurs de logiciels destinés au mass market. Pour tout dire ça m’a plus l’air de pouvoir permettre aux entreprises qui ont jadis massivement investi dans OS/2 de continuer à l’exploiter que de constituer un retour sur le devant de la scène.

Je ne sais pas du coup si on doit voir ça comme une sorte de syndrome COBOL applioqué à un OS. Dans le sens où des tas de softs pointus et critiques tournent en COBOL, on peut même lire de très élogieux plaidoyers sur la performance et la robustesse de cette techno, mais pourtant le monde s’accorde à dire que c’est pas ça l’avenir…

Comme je l’ai dit il s’agissait d’une discussion plus théorique que pratique. Les amateurs ont souvent du mal avec les discussions théorique et ne voient que la pratique, celle qui est simple à comprendre. C’est normal, une discussion théorique demande beaucoup plus de bagage technique et d’expérience dans le domaine.

Quand au déclin, tout ce que je peux vous dire, c’est qu’un retour d’OS/2 au devant de la scène n’est absolument pas à écarter dans les prochaines années. Je dispose d’informations que vous n’avez pas à ce sujet, ayant la possibilité d’échanger avec divers experts reconnus dans le domaine. Wait and see.

basées sur Centos : Asterisk et FreePBX, qui sont quasi exclusivement utilisées au niveau pro

basée sur OpenSuse : Gecko

Merci pour les précisions. Quant à OpenSuSE, vu son nombre de rachats depuis sa naissance, on se demande comment elle fait pour être encore en vie 🙂

Pour la virtualisation je pense que si on est équipé en 64bit mieux vaut tester du 32bit surtout avec les solution dite grand public.

L’idéal étant d’utiliser des hyperviseur on reste sur une base plus légère.

Après

Il me semblait que la suse est une distribution fille de la slackware avec l’ajout de la gestion des rpm.

Après de toute façon à part une quinzaine de distribution le reste est inutile.

Le 32 bits est en fin de vie. Il suffit de voir le nombre de distributions qui l’ont abandonné ou envisage de l’abandonner.

SuSE est à l’origine une base slack, mais rpmisée avec l’inutilement lourd et redondant Yast.

Pour ta conclusion, je suis d’accord pour le domaine bureautique.

Franchement pas sûr, je n’ai pas de chiffres à l’appui mais j’ai du mal à imaginer pourquoi ça se passerait mieux ainsi que si l’host et l’invité partagent la même architecture, sur un proco x64.

Je pousserai le bouchon vachement plus loin, à mon avis 15 c’est déjà limite ridicule. Surtout pour des besoins qui sont à 99% identiques.

En réalité il n’y aurait besoin que d’une version orientée serveur, et une orientée desktop. Puis ensuite quelques trucs plus spécialisés.

Personne n’a jamais exigé d’avoir 15 versions de macOSX, d’android, de symbian ou de windows en parallèle. En général plus il y a de versions dans la nature plus les softs qui se reposent dessus sont difficiles à créer et à supporter. La diversité qui soit disant fait la force des distros linux c’est aussi ce qui fait que lorsque vous cherchez des solutions à un problème sur le net vous n’êtes jamais sûr que la solution est transposable à votre cas, ou du moins pas sans une compréhension assez importante de votre système.

@Jean-Louis merci pour ton dernier commentaire. je trouve que quand tu te regarde moins le nombril tu arrives à faire passer quelque chose, y’a du mieux.

Concernant t’es commentaires de grand expert, tu sais qu’un moteur de recherche nous en apprend plus sur OS/2 que ce que tu nous a laissé entrevoir ? non pas que je remette en cause ton expertise, mais ta capacité à vulgariser les choses. après, on peut pas être expert en tout …

Ca pourrait encore être intéressant mais si la condescendance restait vendue en option ça m’arrangerait.

Mais admettons… Il y a environ 5 ans, j’entendais les mêmes discours sur SmartOS qui allait éjecter linux du monde serveur de par sa robustesse et ses performances. Je pense que tous les OS ont eu à un moment ou un autre leur lot de fervents supporters et des rêves de domination de marché.

En tant qu’expert d’une expertise inégalée qui prend son café avec les experts de ce monde, il est impossible que tu ne te rendes pas compte de la considérable, immense force de frappe qu’il faut pour pousser un OS sur le marché au détriment des acteurs bien établis. Il ne faudrait pas seulement des qualités techniques, mais un mouvement très puissant incluant des fabricants de matériel, des éditeurs de logiciels, du makerting etc… Et pour le moment, si on s’en tient à la chose la plus concrète citée jusqu’ici, soit ArcaOS, non seulement c’est clairement un truc de niche mais le simple nom « Arca noae » (arche de noé) évoque plutôt le sauvetage in-extremis d’un truc qui va disparaître. Tu admettras qu’il est fort difficile d’imaginer un retour en fanfare sur la base de ces éléments.

Les qualités techniques, mêmes si elles sont extraordinaires (et ça je concède que c’est reconnu pour OS/2 à son époque), ne rendent pas nécessairement un outil exploitable dans l’industrie sans un écosystème de qualité et une stratégie pour pousser à l’adoption. Pour prendre la programmation qui est mon domaine, des langages meilleures et mieux conçus que, par exemple le C++, il y en a des wagons (de l’aveu même de son créateur), y’a qu’à voir le « D ». Pourtant ils sont pratiquement tous au fond des chiottes pour exactement la même raison, l’écosystème n’est pas là, les investissements ne suivent pas, et du coup c’est pas viable dans l’industrie.