Indiana, c’est le nom d’un projet pour permettre une « vulgarisation » (au sens étymologique du terme, donc rendre populaire) OpenSolaris, la mise sous contrat libre (CDDL) du code source de Solaris.

Avec la sortie d’une RC de la version 2008.05 d’OpenSolaris, c’était le moment d’en profiter pour voir ce que ce projet a dans les tripes. Je tiens à préciser que je ne fais pas un test exhaustif, mais un aperçu de cette version libérée de Solaris.

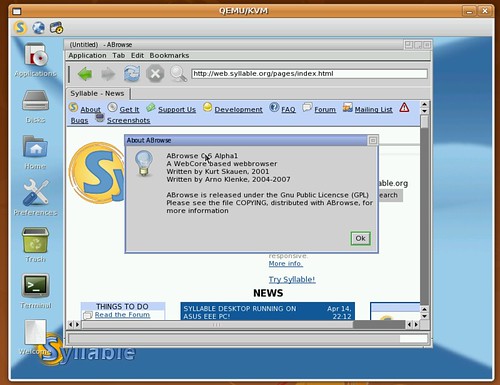

J’utilise donc kvm, après avoir créé une image de disque dur de 32 Go et lancer le démarrage depuis l’image du CD-Rom, clavier français et avec un circuit son es1370.

En clair, j’ai rentré les lignes de commandes suivantes :

fred@fred-laptop:~/download$ qemu-img create -f qcow2 indiana.img 32G

Formatting 'indiana.img', fmt=qcow2, size=33554432 kB

fred@fred-laptop:~/download$ kvm -m 768 -hda indiana.img -cdrom 0805rc2a.iso -k fr -soundhw es1370 -boot d &

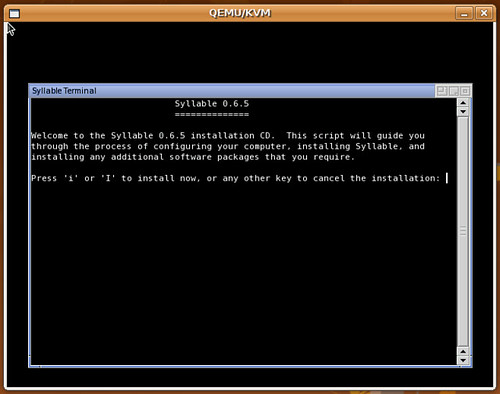

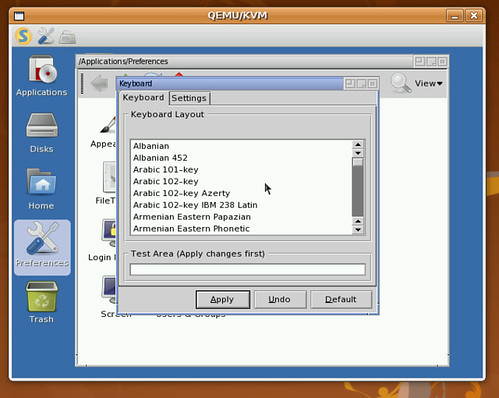

Seul deux questions vous sont posés et bien qu’elles soit en anglais, on les comprends facilement. Elle vous demande le type de clavier à utiliser, et son agencement.

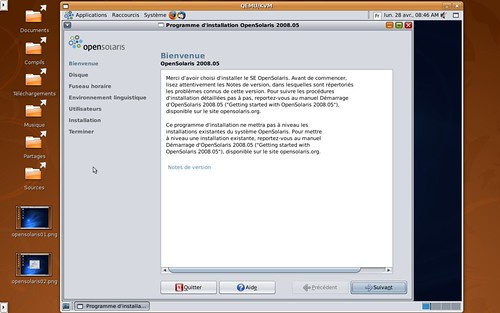

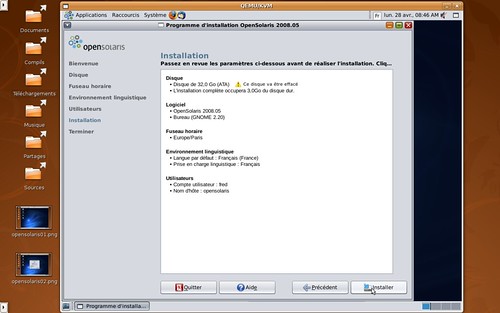

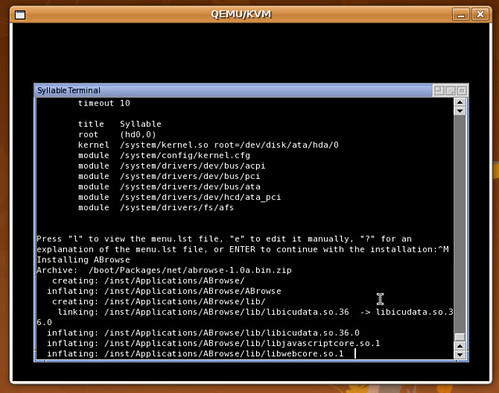

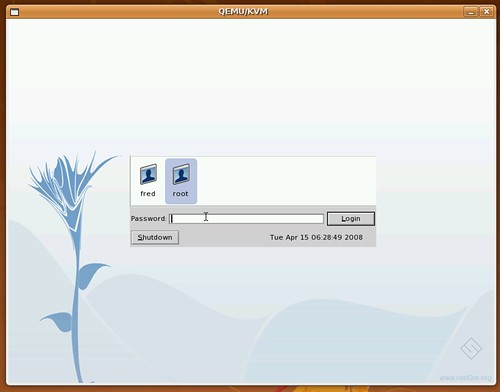

Ensuite, on arrive sous une interface graphique, basée sur Gnome. L’assistant d’installation est assez simple, pour ne pas dire « simpliste » et après quelques questions basique se propose d’installer OpenSolaris sur la machine.

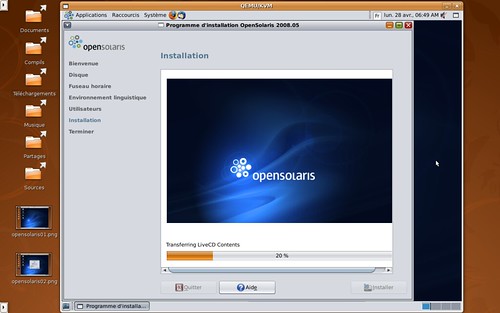

A noter que le système de fichier zfs semble être celui par défaut. L’installation dure une grosse vingtaine de minutes. Et le circuit son émulé n’est pas supporté 🙁

Coté logiciel : Gnome 2.20.2, Firefox 2.0.0.14, Thunderbird 2, Gimp 2.4.1 pour citer les principaux qui sont disponibles dès le début.

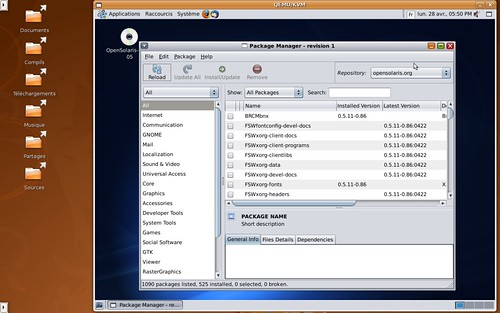

L’ajout de paquet se fait par un outil d’ajout de paquet qui ressemble énormément à Synaptic, ce qui le rend agréable d’utilisation.

On peut ainsi installer OpenOffice.org 2.4.0, les traductions francophones de certains logiciels, etc…

OpenSolaris semble être un OS très prometteur, cependant, il est encore assez peu « mature » pour le grand public. Seul un public passionné d’informatique pourra y trouver son bonheur, surtout s’il veut connaître autre chose que du Linux ou du BSD libre 😉